大模型应用开发系统环境配置

发布时间丨2024-11-08 10:10:01作者丨赵小帆浏览丨1212

第一篇大模型应用开发系统环境配置

自从2020年大模型被人熟知,到现在的人尽皆知的,基本上每个人都或多或少的使用过大模型的能力。由于知识点很多,我准备分4篇文章,从系统环境配置>知识库搭建>提示词优化>系统调优>对接web系统开发一个完整的大模型应用项目!

-

第一篇大模型应用开发系统环境配置

-

第二篇大模型应用知识库搭建

-

第三篇大模型应用模型及提示词优化

-

第四篇大模型应用与halo系统对接

原创不易,请关注公众号:爬虫与大模型开发。大模型的应用开发之路,整理了大模型在现在的企业级应用的实操及大家需要注意的一些RAG开发的知识点!持续输出爬虫与大模型的相关文章。

1 大模型:模型应用篇

市面上使用的大模型

当前最受欢迎的大模型莫过于chatgpt,基本上人人遇到问题都说问问"chatgpt",可是有多少人真的会使用或者真正使用过大模型的呢?

大模型如何使用及使用的体验

访问chatgpt需要科学上网,上图是大模型的使用的提问的首页。

访问chatgpt需要科学上网,上图是大模型的使用的提问的首页。  我们国内的有文心一言、智普清言、豆包、kimi等大模型智能体。在日常的工作办公中使用都是不错的,可以帮助我们提高工作的效率。

我们国内的有文心一言、智普清言、豆包、kimi等大模型智能体。在日常的工作办公中使用都是不错的,可以帮助我们提高工作的效率。

对于大多数的人可以通过这些智能体体验了大模型的“智慧”。但是对于大模型的应用开发着来说需要通过使用大模型的能力,按照我们的业务需求帮助我们完成特定的工作。例如:翻译、文案编写、文档阅读总结、文生图等。

现在的大模型如雨后的春笋,满地都是,各种新的训练的多模型态大模型带给我们新的认知。做大模型开发需要考虑模型的使用的成本、数据的安全性、模型的能力、数据的时效性等问题。因此就安全性而言,最好可以使用本地自己部署的大模型,老板才会觉着“安心“。对于模型的能力。本地部署大模型现在有千问quen系类、llama系列等可以本地部署。我们使用ollama、oneapi等下载部署本地的大模型!

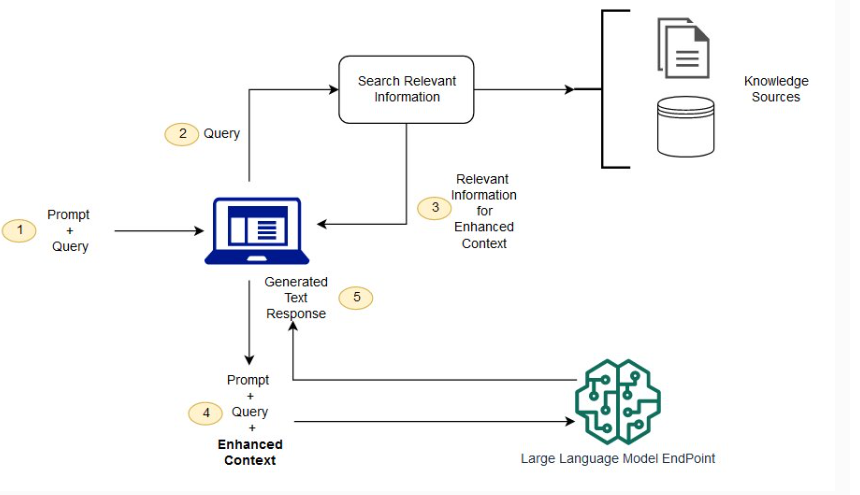

大模型具有时效性的问题,不呢能回答最新的信息,这个是大模型现在的缺点,但是随着技术的发展我们可以本地微调大模型,可以在一定的程度上让大模型在垂直领域拥有大量的数据知识。我们还可以通过RAG(J检索、生成、增强)来解决大模型的这个缺点。

演示安装ollama

-

下载地址:https://ollama.com/download

-

安装模型

ollama list 查看安装的模型

ollama install qwen:7b

ollama run qwen:7b

service ollama stop 停止服务

默认是绑定在127.0.0.1的IP,若需要绑定到外部访问,那么采用如下:

export OLLAMA_HOST=0.0.0.0:11434

RAG优势(知识库的核心)

RAG的一个特点是它将通用的大规模语言模型与信息检索相结合。此配置具有以下优点:

・信息更新方便 通过更新被视为外部信息的文档和数据库,RAG可以让最新的信息立即反映在大规模语言模型的输出结果中。与仅使用大规模语言模型的配置相比,不需要重新训练模型,这可能会降低成本。

・输出结果的可靠性 RAG利用外部信息搜索结果输出答案,使依据清晰,增加答案的可靠性。此外,大规模语言模型有望降低产生幻觉的风险。

检索增强生成和语义搜索有什么区别?

-

语义搜索可以提高 RAG 结果,适用于想要在其 LLM 应用程序中添加大量外部知识源的组织。现代企业在各种系统中存储大量信息,例如手册、常见问题、研究报告、客户服务指南和人力资源文档存储库等。上下文检索在规模上具有挑战性,因此会降低生成输出质量。

-

语义搜索技术可以扫描包含不同信息的大型数据库,并更准确地检索数据。例如,他们可以回答诸如 “去年在机械维修上花了多少钱?”之类的问题,方法是将问题映射到相关文档并返回特定文本而不是搜索结果。然后,开发人员可以使用该答案为 LLM 提供更多上下文。

-

RAG 中的传统或关键字搜索解决方案对知识密集型任务产生的结果有限。开发人员在手动准备数据时还必须处理单词嵌入、文档分块和其他复杂问题。相比之下,语义搜索技术可以完成知识库准备的所有工作,因此开发人员不必这样做。它们还生成语义相关的段落和按相关性排序的标记词,以最大限度地提高 RAG 有效载荷的质量。

2 应用开发篇:系统安装篇

有很多的工具可以来开发我们的大模型应用例如maxkb、dify、fastgpt、langchain等。今天介绍一个开源的一站式部署大模型实现系统环境的安装功工具:1panel一个linux运维系统。

-

按装下载:https://1panel.cn/

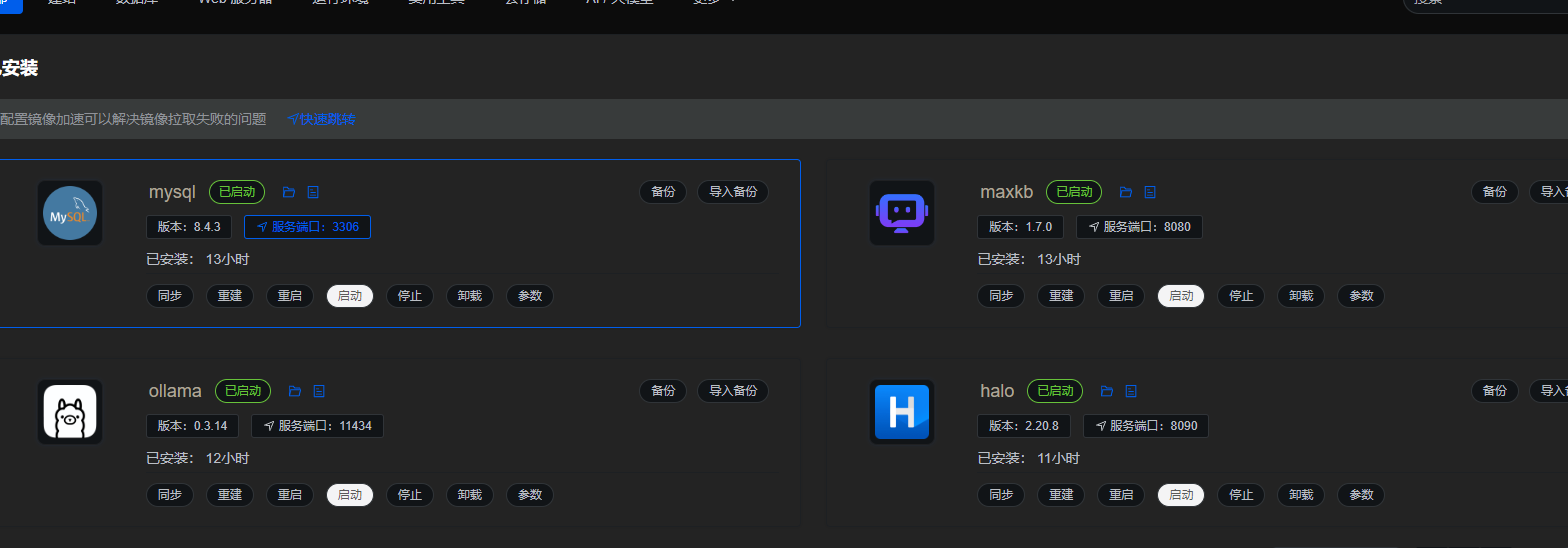

下面我们使用1panel面板下载我们所有的需要的开发工具及系统,安装如下图:、

下面我们使用1panel面板下载我们所有的需要的开发工具及系统,安装如下图:、

按照上图的安装这些数据库和知识库系统、crm博客系统。我们还可以使用它安装ollama!安装需要一些时间,完成后如下图:

按照上图的安装这些数据库和知识库系统、crm博客系统。我们还可以使用它安装ollama!安装需要一些时间,完成后如下图:

安装成功后分别查看安装的结果:

-

maxkb 地址:http://ip:8080/ui/login

-

ollama 地址:http://ip:11434

-

halo 地址:http://ip:8090/

小结

企业级大模型知识库开发涉及的比较的知识点多,公众号的篇幅有限,因此我决定分4个篇幅来为大家奉上!以上是大模型应用开发的第一篇!

-

第一篇大模型应用开发系统环境配置

-

第二篇大模型应用知识库搭建

-

第三篇大模型应用模型及提示词优化

-

第四篇大模型应用与halo系统对接

完结

原创不易,点个关注!

不会错过后面的js逆向文章!

觉着写的不错的可以帮忙点点赞。

关注公众号:爬虫与大模型开发。

需要以上源代码的下面留言:“想要代码”。

活跃在一线的爬虫工程师分享自己学习之路

我创建了爬虫与大模型开发的星球群

适合爱好爬虫及从事爬虫的同学

代码相关内容我放到了星球